Inception神经网络

Inception网络

1.Inception网络简介

Inception网络又叫做GoogLeNet,之所以不叫GoogleNet,是为了向LeNet致敬,是2014年ChristianSzegedy在《Going deeper with convolutions》提出的一种全新的深度学习结构。

一般来说,提升网络性能最保险的方法就是增加网络的宽度和深度,这样做同时也会伴随着副作用。首先越深越宽的网络往往会意味着有巨大的参数量,当数据量很少的时候,训练出来的网络很容易过拟合,并且当网络有很深的深度的时候,很容易造成梯度消失现象这两个副作用制约着又深又宽的卷积神经网络的发展,Inception网络很好的解决了这两个问题。

2.Inception网络模块

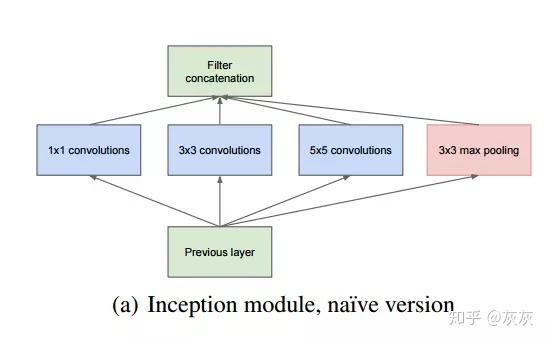

下图是Inception中的一个模块,Inception由多个这样的模块组合而成的。

Inception网络结构中其中一个模块是这样的:在同一层中,分别含有1*1、3*3、5*5卷积和池化层,在使用filter进行卷积操作与池化层进行池化操作时都会使用padding以保证输出都是同尺寸大小,经过这些操作后输出的结果也就是特征图Featuremap再全部整合在一起。该模块的特性就是在同一层中,分别通过使用上述不同尺寸的filter与进行池化操作收集到了上一层输入的不同特征。这样就增加了网络的宽度,用这些不同尺寸的滤波器和池化操作去提取上一层的不同特征。

但是这样存在一个问题,经过这样一个模块后,输出的特征图往往很大(就是太长了),这样用不了几层就会造成参数过多并且计算量过大的问题,为了解决这个问题,使用了如下的构造:

相比于上一个原始的Inception模块,模型中在3*3卷积层和5*5卷积层前增加了1*1的卷积层,并在池化层后增加了1*1的卷积层。这样做的意义是减少了参数量,避免了每层的计算量过大。

3.Inception网络降低参数计算量

1*1卷积降低参数和计算量:

如上图所示,针对5*5卷积的这一层,不包含1*1的卷积模块时,参数量为5*5*256*64=409600个参数,连接数为(5*5*256+1)*64*n*n=409664*n*n个。而包含1*1的卷积模块时,参数量为1*1*256*32+5*5*32*64=59392个参数,连接数为((1*1*256+1)*32*n*n+(5*5*32+1)*64*n*n)=59488*n*n个。由此可见,包含1*1的卷积模块比不包含的参数数量和计算量要少很多。

这样Inception很好的缓和了因扩大网络宽度而造成的计算量过大和过拟合问题。

4.Inception网络减缓梯度消失现象

Inception网络框架中会有额外的两个softmadx预测层,这两个预测层分别是从网络框架中间部分引出的分支,用于反向传播更新梯度,这样就避免了因梯度消失导致浅层的网络参数无法更新。注意这两个分支只在训练的时候防止梯度消失会用到,真正做预测的时候需要删除。

5.Inception网络框架

就是一个个Inception网络堆砌而成

6.Inception论文彩蛋

以上就是关于Inception网络的介绍,顺便说一下Christian Szegedy在发表该网络的论文《Going deeper with convolutions》中附了一个小彩蛋,就是下图,表明了往更深层次网络架构发展的决心,其实将该网络取名Inception,就是《盗梦空间》的名称。

Inception神经网络相关推荐

- 2.1 为什么要进行实例探究-深度学习第四课《卷积神经网络》-Stanford吴恩达教授

←上一篇 ↓↑ 下一篇→ 1.12 总结 回到目录 2.2 经典网络 为什么要进行实例探究 (Why look at case studies?) 这周我们首先来看看一些卷积神经网络的实例分析,为什么 ...

- 深度学习笔记 第四门课 卷积神经网络 第二周 深度卷积网络:实例探究

本文是吴恩达老师的深度学习课程[1]笔记部分. 作者:黄海广[2] 主要编写人员:黄海广.林兴木(第四所有底稿,第五课第一二周,第三周前三节).祝彦森:(第三课所有底稿).贺志尧(第五课第三周底稿). ...

- 深度学习入门笔记(二十):经典神经网络(LeNet-5、AlexNet和VGGNet)

欢迎关注WX公众号:[程序员管小亮] 专栏--深度学习入门笔记 声明 1)该文章整理自网上的大牛和机器学习专家无私奉献的资料,具体引用的资料请看参考文献. 2)本文仅供学术交流,非商用.所以每一部分具 ...

- 吴恩达深度学习 | (18) 卷积神经网络专项课程第二周学习笔记

课程视频 第二周PPT汇总 吴恩达深度学习专项课程共分为五个部分,本篇博客将介绍第四部分卷积神经网络专项的第二周课程:深度卷积网络:实例探究. 目录 1. 为什么要进行实例探究 2. 经典网络 3. ...

- 吴恩达深度学习课程之第四门课 卷积神经网络 第二周 深度卷积网络

本文参考黄海广主编针对吴恩达深度学习课程DeepLearning.ai <深度学习课程 笔记 (V5.1 )> 第二周 深度卷积网络 2.1 为什么要进行实例探究?(Why look at ...

- 吴恩达deeplearning.ai系列课程笔记+编程作业(11)第四课 卷积神经网络-第二周 深度卷积网络:实例探究(Deep convolutional models: case studies)

第四门课 卷积神经网络(Convolutional Neural Networks) 第二周 深度卷积网络:实例探究(Deep convolutional models: case studies) ...

- 吴恩达深度学习课程笔记之卷积神经网络(2nd week)

0 参考资料 [1] 大大鹏/Bilibili资料 - Gitee.com [2] [中英字幕]吴恩达深度学习课程第四课 - 卷积神经网络_哔哩哔哩_bilibili [3] 深度学习笔记-目录 ...

- grpc_模型服务:流处理与使用Java,gRPC,Apache Kafka,TensorFlow的RPC / REST

grpc 机器学习/深度学习模型可以通过不同的方式进行预测. 我的首选方法是将分析模型直接部署到流处理应用程序(如Kafka Streams或KSQL )中. 您可以例如使用TensorFlow fo ...

- kafka grpc_模型服务:流处理与使用Java,gRPC,Apache Kafka,TensorFlow的RPC / REST

kafka grpc 机器学习/深度学习模型可以通过不同的方式进行预测. 我的首选方法是将分析模型直接部署到流处理应用程序(如Kafka Streams或KSQL )中. 您可以例如使用TensorF ...

最新文章

- CGContextSaveGState与CGContextRestoreGState的作用

- PyTorch基础(part3)

- 原生js循环展示dom_为什么说JS的DOM操作很耗性能

- 在Maple 9中察看内置函数的原代码的三种方法

- Grails里的集成测试代码试例

- UGUI更换图片的三种方法

- 想在体制内吃得开,不要有这5种表现,不受领导待见,越混越糟糕

- 通过crond定时任务自动更新动态IP到PubYun(3322)实现远程访问

- 无线串口服务器规模,无线串口服务器

- pe制作linux硬盘的镜像文件_用WindowsPE制作的启动U盘或移动硬盘安装cent os 6.2

- 【Unity】3D雷霆战机

- 语言栏多出EN、JP等键盘布局的解决方案

- 梦三花重金修改服务器,《新天龙八部》6月14日全服更新维护公告

- linux查看服务器用户名密码,怎么查看linux服务器的配置?

- 有关与windows的一些资料以及链接(一)

- 首旅如家蝉联世界酒店集团10强,中高端酒店开业超1000家

- 阿里云学生成长计划续费资格考试

- Hadoop HIPI

- phpstudy 404页面设置 也就是Apache404页面的设置

- Visual.Basic程序设计教程题解与上机指导(第四版)pdf