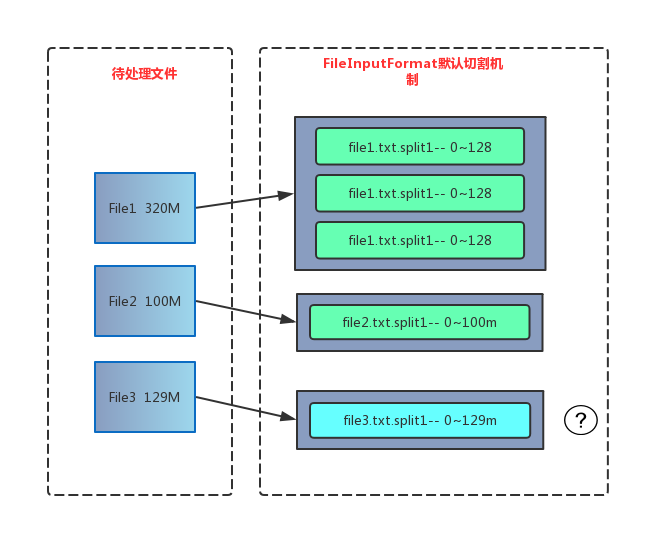

Hadoop FileInputFormat 默认切片机制

默认的切片机制

- 简单地按照文件的内容长度进行切片

- 切片大小,默认等于 block 大小**(Local模式默认32M,集群模式默认128M)**

- 切片时不考虑数据集整体,而是逐个针对每一个文件单独切片

源码分析

参考:Hadoop MapReduce Splits 切片源码分析及切片机制

计算切片大小 computeSplitSize

默认情况下,切片大小=blocksize

protected long computeSplitSize(long blockSize, long minSize, long maxSize) {return Math.max(minSize, Math.min(maxSize, blockSize));

}

SPLIT_SLOP

每次切片时,都要判断切完剩下的部分是否大于块的 1.1 倍, 不大于 1.1 倍就划分一块切片

private static final double SPLIT_SLOP = 1.1; // 10% slop

while (((double) bytesRemaining)/splitSize > SPLIT_SLOP) {int blkIndex = getBlockIndex(blkLocations, length-bytesRemaining);splits.add(makeSplit(path, length-bytesRemaining, splitSize, blkLocations[blkIndex].getHosts(),blkLocations[blkIndex].getCachedHosts()));bytesRemaining -= splitSize;

}

通过分析源码,在 FileInputFormat 中,计算切片大小的逻辑:Math.max(minSize,

Math.min(maxSize, blockSize));

切片主要由这几个值来运算决定

mapreduce.input.fileinputformat.split.minsize=1 //默认值为 1

mapreduce.input.fileinputformat.split.maxsize= Long.MAXValue //默认值

因此,默认情况下,切片大小=blocksize。

maxsize(切片最大值):参数如果调得比 blocksize 小,则会让切片变小,就等于

配置的这个参数的值。

minsize(切片最小值):参数调的比 blockSize 大,则可以让切片变得比 blocksize 还大

Hadoop FileInputFormat 默认切片机制相关推荐

- 他来了他来了,Hadoop序列化和切片机制了解一下?

点击上方蓝色字体,选择"设为星标" 回复"面试"获取更多惊喜 切片机制 一个超大文件在HDFS上存储时,是以多个Block存储在不同的节点上,比如一个512M的 ...

- 【Hadoop】MR 切片机制 MR全流程

1.概念 2.Split机制 3.MR Shuffle过程 4.MR中REDUCE与MAP写作过程 5.MR全貌 转载于:https://www.cnblogs.com/junneyang/p/585 ...

- Hadoop中的FileInputFormat切片机制、FileInputFormat切片大小的参数配置、TextInputFormat、CombineTextInputFormat切片机制

文章目录 13.MapReduce框架原理 13.1InputFormat数据输入 13.1.4FileInputFormat切片机制 13.1.4.1切片机制 13.1.4.2案例分析 13.1.4 ...

- 【hadoop】20.MapReduce-InputFormat数据切片机制

2019独角兽企业重金招聘Python工程师标准>>> 简介 通过本章节,您可以学习到: Job的提交流程 InputFormat数据切片的机制 1.Job提交流程源码分析 1)jo ...

- MapTask并行度决定机制、FileInputFormat切片机制、map并行度的经验之谈、ReduceTask并行度的决定、MAPREDUCE程序运行演示(来自学笔记)

1.3 MapTask并行度决定机制 maptask的并行度决定map阶段的任务处理并发度,进而影响到整个job的处理速度 那么,mapTask并行实例是否越多越好呢?其并行度又是如何决定呢? 1.3 ...

- FileInputFormat切片机制和实现类

Hadoop学习 FileInputFormat切片机制和实现类 FileInputFormat切片机制 CombineTextInputFormat切片机制 CombineTextInputForm ...

- FileInputFormat切片机制和配置参数

1. FileInputFormat中默认的切片机制 (1)简单地按照文件的内容长度进行切片 (2)切片大小,默认等于block大小(本地模式块大小32M,yarn模式128M,老的版本64M) (3 ...

- 大数据之-Hadoop3.x_MapReduce_FileInputFormat切片机制---大数据之hadoop3.x工作笔记0106

然后我们再来看一下这个FileInputFormat的切片机制,可以看到 实际上切片就是按照文件的长度,一个切片大小默认等于块大小,切片是逻辑切片,不是物理切片 仅仅是做了标记 然后切片时不考虑数据 ...

- Hadoop MapReduce Splits 切片源码分析及切片机制

本文从Job提交,逐步分析Splits相关源码. 数据块:Block是HDFS物理上把数据分成一块一块的. 数据切片:数据切片只是在物理上输入进行分片,并不会在磁盘上将其分成片进行存储. 文件路径 o ...

最新文章

- dataGridView1去掉第一列

- 信息网络传播权保护条例(2006)

- mongodb数据可视化_使用MongoDB实时可视化开放数据

- C/C++ ultoa函数 - C语言零基础入门教程

- 软件测试技术第一次试验之——JUnit的安装与使用

- js中精度问题以及解决方案

- python 3.5 format_python 3.5学习笔记(第四章)

- Python_二维数组

- 如何在虚拟机安装windows server 2003

- 喵咪制造机:生成式对抗网络的花式画喵大法

- android 玩pc游戏,如何在您的Android设备上玩经典PC游戏 | MOS86

- illegal offset type php,PHP warning Illegal offset type错误解决办法

- csrf 功能 及 csrf装饰器使用

- 五分钟掌握计时器CountDownTimer,快速实现倒计时功能

- UGUI动画快速制作

- jar包是干什么用的

- Python语言程序设计 - 测验6: 组合数据类型 (第6周)

- k8s进阶篇-云原生存储ceph

- hdu 6217 BBP Formula

- 免安装:MySQL配制