[深度学习] Relu层作用

为什么引入非线性激励函数

如果不用激励函数,在这种情况下你每一层输出都是上层输入的线性函数,很容易验证,无论你有多少层神经网络,输出的都是输入的线性组合。

激活函数是用来加入非线性因素的,因为线性模型的表达能力不够。

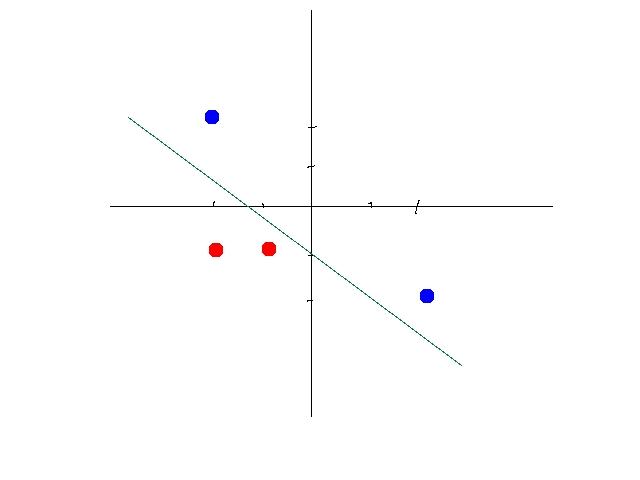

以下,同种颜色为同类数据。某些数据是线性可分的,意思是,可以用一条直线将数据分开。比如下图:

这时候你需要通过一定的机器学习的方法,比如感知机算法(perceptron learning algorithm) 找到一个合适的线性方程。

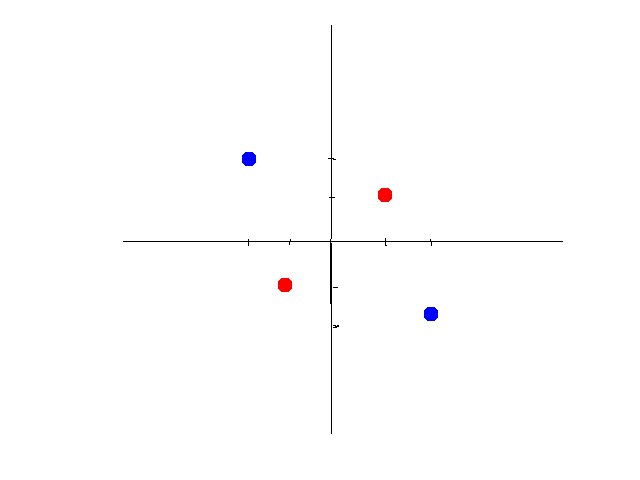

但是有些数据不是线性可分的。比如如下数据:

第二组数据你就没有办法画出一条直线来将数据区分开。

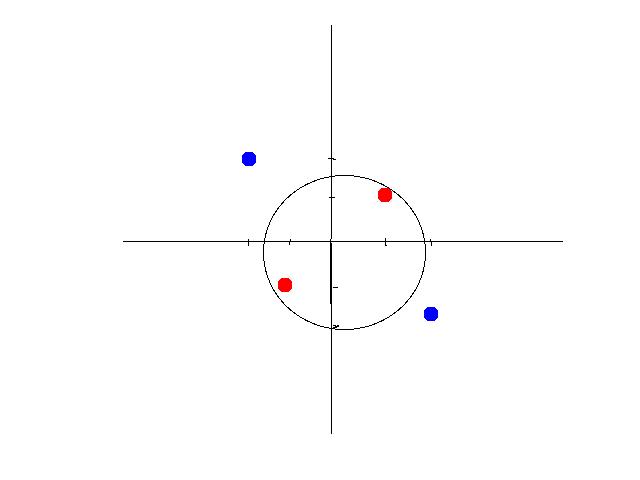

这时候有两个办法,第一个办法,是做线性变换(linear transformation),比如讲x,y变成 x2,y2 x 2 , y 2 x^2,y^2,这样可以画出圆形。如图所示:

如果将坐标轴从x,y变为以 x2,y2 x 2 , y 2 x^2,y^2为标准,你会发现数据经过变换后是线性可分的了。大致示意图如下:

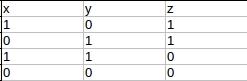

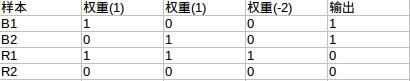

另外一种方法是引入非线性函数。我们来看异或问题(xor problem)。以下是xor真值表

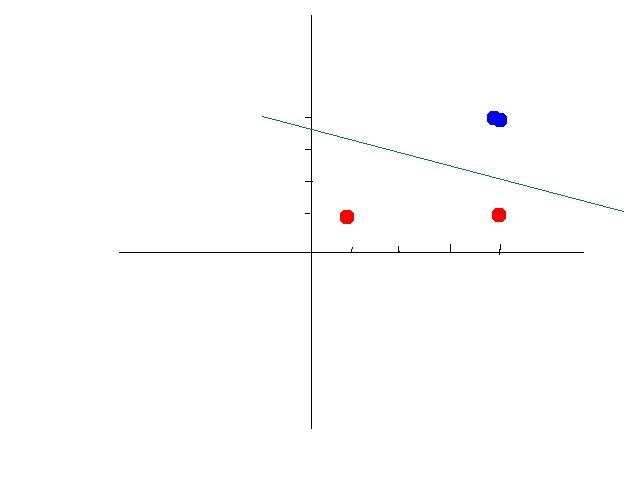

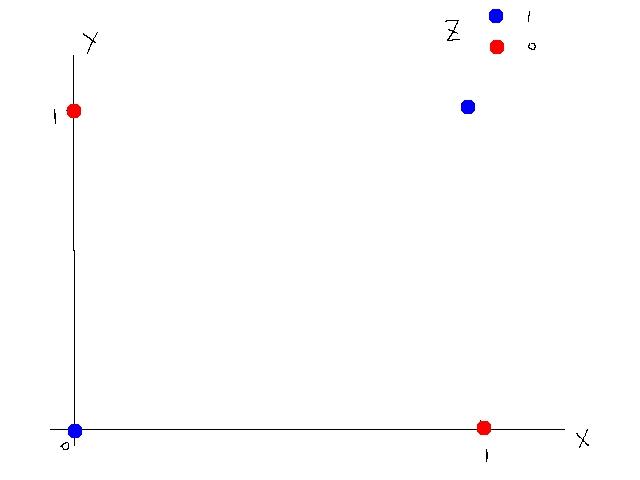

这个真值表不是线性可分的,所以不能使用线性模型,如图所示

我们可以设计一种神经网络,通过激活函数来使得这组数据线性可分。

激活函数我们选择阀值函数(threshold function),也就是大于某个值输出1(被激活了),小于等于则输出0(没有激活)。这个函数是非线性函数。

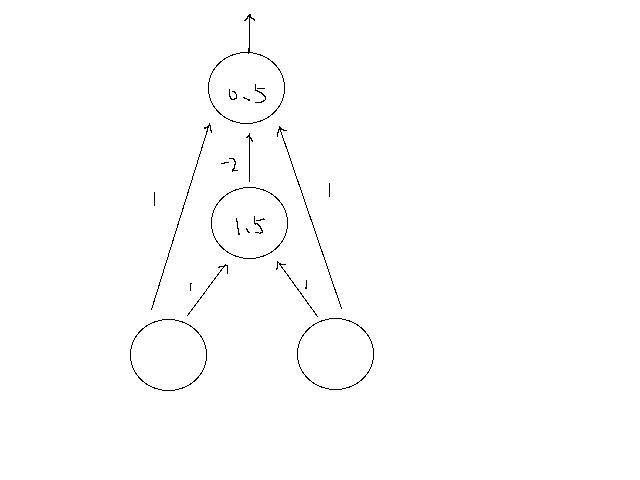

神经网络示意图如下:

其中直线上的数字为权重。圆圈中的数字为阀值。第二层,如果输入大于1.5则输出1,否则0;第三层,如果输入大于0.5,则输出1,否则0.

我们来一步步算。

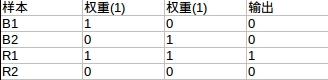

第一层到第二层(阀值1.5)

第二层到第三层(阀值0.5)

可以看到第三层输出就是我们所要的xor的答案。

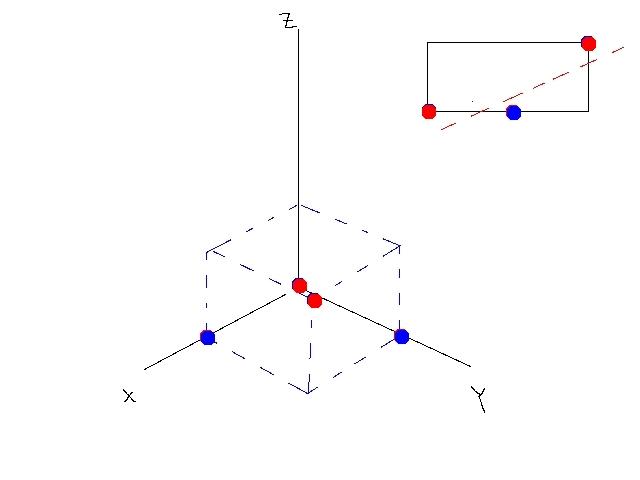

经过变换后的数据是线性可分的(n维,比如本例中可以用平面),如图所示:

总而言之,激活函数可以引入非线性因素,解决线性模型所不能解决的问题。

- 为什么引入Relu呢

第一,采用sigmoid函数,算激活函数时(指数运算),计算量大。而使用Relu,整个计算节省了很多。

第二,对于深层网络,sigmoid函数反向传播时,很容易出现梯度消失的情况,(sigmoid接近饱和区的时候,变化太缓慢,导数趋于0)从而无法完成深层网络的训练。

第三,Relu会使一部分神经元的输出为0,这样就造成了网络的稀疏性,并且减少了参数之间互相依存的关系,缓解了过拟合的发生。

参考

https://www.zhihu.com/question/22334626

[深度学习] Relu层作用相关推荐

- 深度学习 | BN层原理浅谈

深度学习 | BN层原理浅谈 文章目录 深度学习 | BN层原理浅谈 一. 背景 二. BN层作用 三. 计算原理 四. 注意事项 为什么BN层一般用在线性层和卷积层的后面,而不是放在激活函数后 为什 ...

- 吴恩达神经网络与深度学习——浅层神经网络

吴恩达神经网络与深度学习--浅层神经网络 神经网络概述 神经网络表示 计算神经网络的输出 m个样本的向量化 for loop 向量化 向量化实现的解释 激活函数 sigmoid tanh函数 ReLu ...

- 深度学习pytorch--多层感知机(一)

多层感知机 隐藏层 激活函数 ReLU函数 sigmoid函数 tanh函数 多层感知机 小结 我们已经介绍了包括线性回归和softmax回归在内的单层神经网络.然而深度学习主要关注多层模型.在本节中 ...

- 卷积在深度学习中的作用(转自http://timdettmers.com/2015/03/26/convolution-deep-learning/)...

卷积可能是现在深入学习中最重要的概念.卷积网络和卷积网络将深度学习推向了几乎所有机器学习任务的最前沿.但是,卷积如此强大呢?它是如何工作的?在这篇博客文章中,我将解释卷积并将其与其他概念联系起来,以帮 ...

- 深度学习跨层网络结构--特征融合

网络连接结构 个人理解,如有偏差,欢迎指出. ResNet ResNet ResNet 为了解决模型退化问题,创新性的使用了恒等映射,将上一层可能不需要改变的信息,通过跨层链接以逐个相加的方式,叠加到 ...

- Mish-撼动深度学习ReLU激活函数的新继任者

对激活函数的研究一直没有停止过,ReLU还是统治着深度学习的激活函数,不过,这种情况有可能会被Mish改变. Diganta Misra的一篇题为"Mish: A Self Regulari ...

- 深度学习ReLU激活函数

ReLU激活函数 在深度学习中,有修正线性单元(Rectified linear unit,ReLU)的激活函数 x轴是时间,y轴是放电速度 神经元的工作方式: 1.稀疏性 2.分布性 我们开始介绍R ...

- matlab“机器学习和深度学习”系列工具箱作用总结

这是MATLAB r2019a的"机器学习和深度学习"工具箱 1,Classification Learner工具箱 打开之后的界面,主要用于分类 具体用法见: MATLAB自带分 ...

- 卷积在深度学习中的作用

转自 http://www.mamicode.com/info-detail-2340306.html 卷积可能是现在深入学习中最重要的概念.卷积网络和卷积网络将深度学习推向了几乎所有机器学习任务的 ...

最新文章

- GPU自动调度卷积层

- (转)Android中截取当前屏幕图片

- HTML DOM Element 对象

- LLVM笔记(5) - SMS

- 手机黑圆点怎么打_手机能「打快板」是怎么回事?浅谈手机的光学防抖

- 自动驾驶—— Image Caption的学习笔记(legacy)

- windowsError错误码详解

- unity,生成的mac版游戏切场景时卡死解法

- 拇指接龙游戏中的Undo道具与STL容器deque简介

- html转到百度的链接,简易制作百度跳转链接

- ssh远程连接Ubuntu 20.04

- Stata进行logistic回归绘制列线图并做内部验证

- java导出excel设置行高列宽_Java 设置Excel自适应行高或列宽

- 【论文阅读】Recurrent Chunking Mechanisms for Long-Text Machine Reading Comprehension

- Android上的Dalvik虚拟机

- 详解STM32中的ADC

- sed 删除/增加文件的某一行

- 【perl】正则匹配中的括号套括号的套娃抓取规则

- 存储新图谱:DNA存储的边界与天地

- 布尔运算 : ^(异或运算XOR)、(与运算AND)、|(或运算OR)、 、~(非门NOT)