ResNet网络的搭建

文章目录

- 亮点

- 残差结构

- 计算量

- 虚线残差结构

- 代码解析

- resnet18/34的残差结构

- resnet50/101/152的残差结构Bottleneck

- 一层layer的结构(_make_layer()函数)

- ResNet主网络

- 代码仓库

亮点

引入了残差结构

使用Batch Normalization加速训练(丢弃dropout)

这两个方法,解决了梯度消失和梯度爆炸等问题,使得构建深层网络成为可能

残差结构

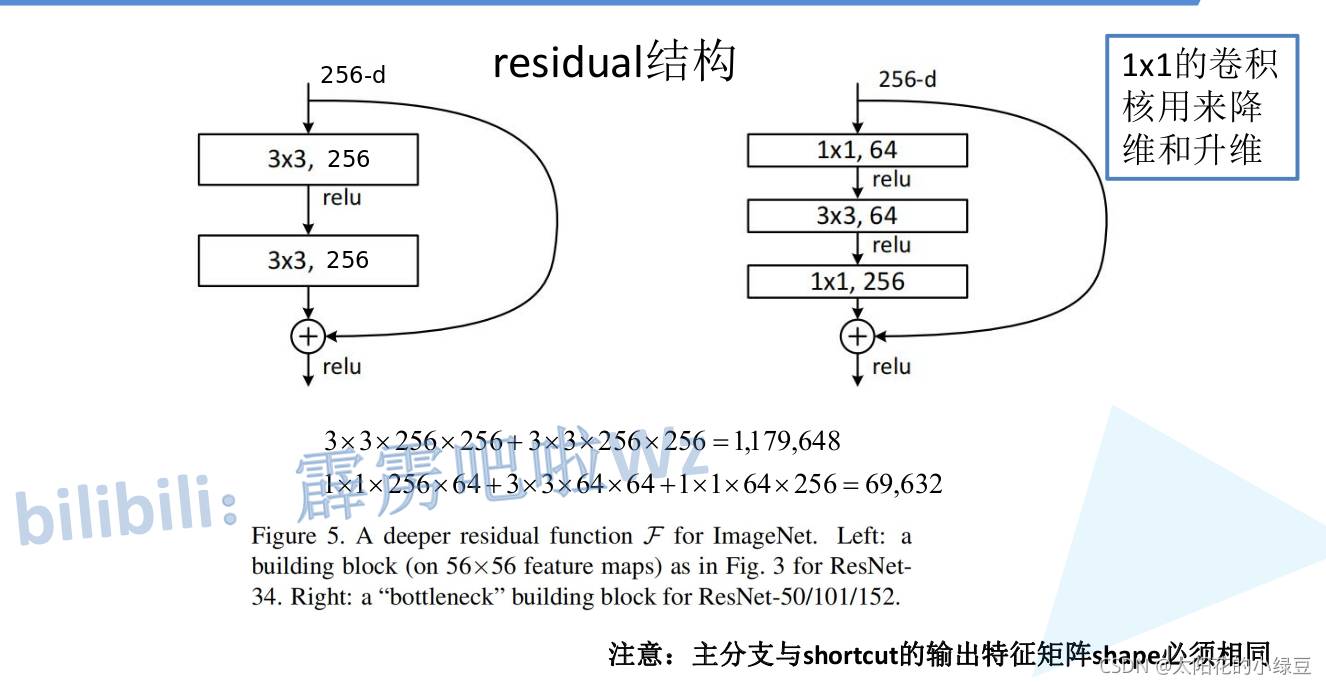

计算量

左边是ResNet18/34的残差结构,右边是ResNet101/152的残差结构

- 左边计算量:3x3x256x256+3x3x256x256=1179648

- 右边计算量:1x1x256x64+3x3x64x64+1x1x64x256=69632

由此可见,右边一个残差结构的计算量更少,原因是右边的残差结构,使用阿一个1*1的卷积核,用来降维和升维

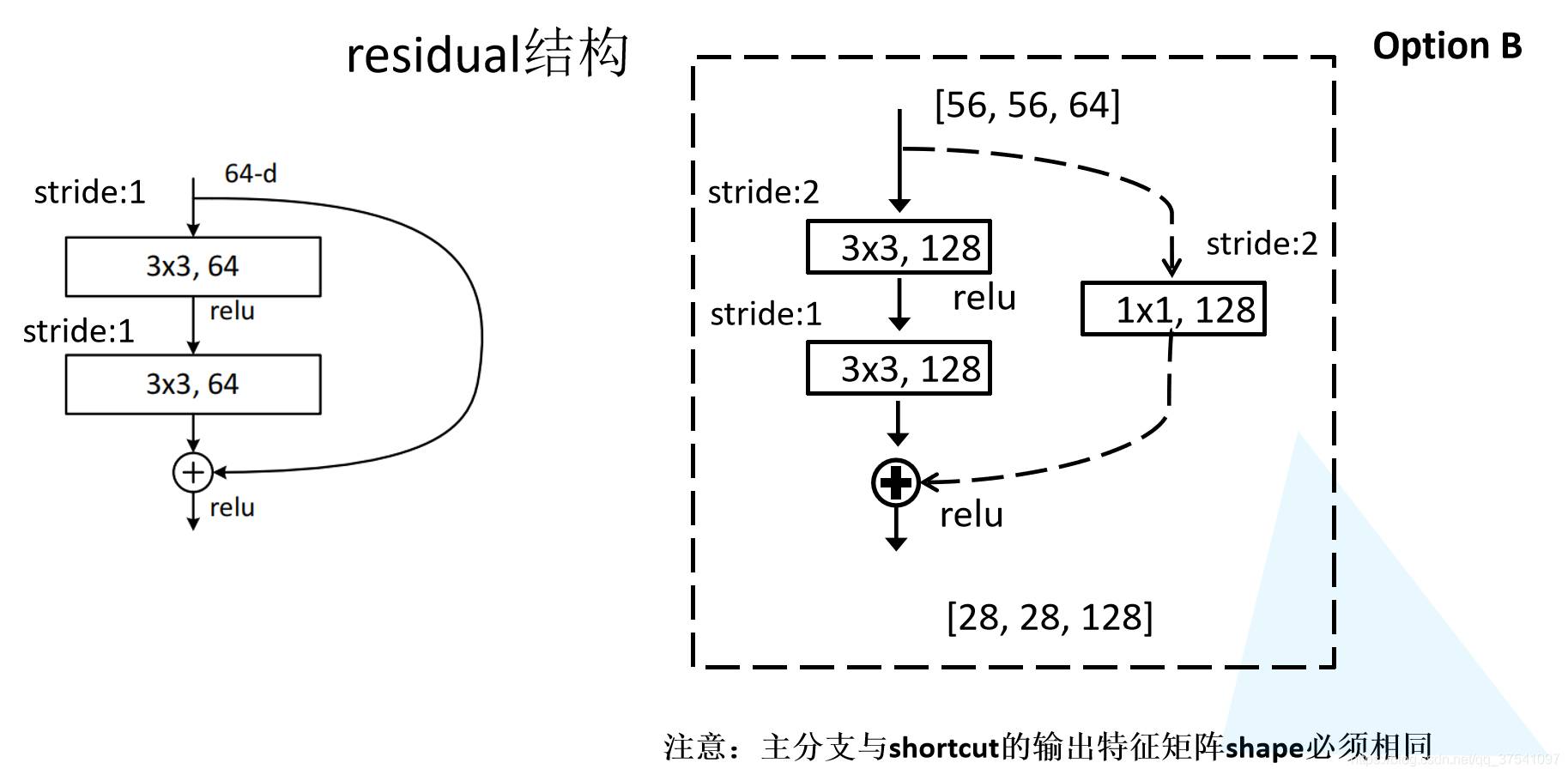

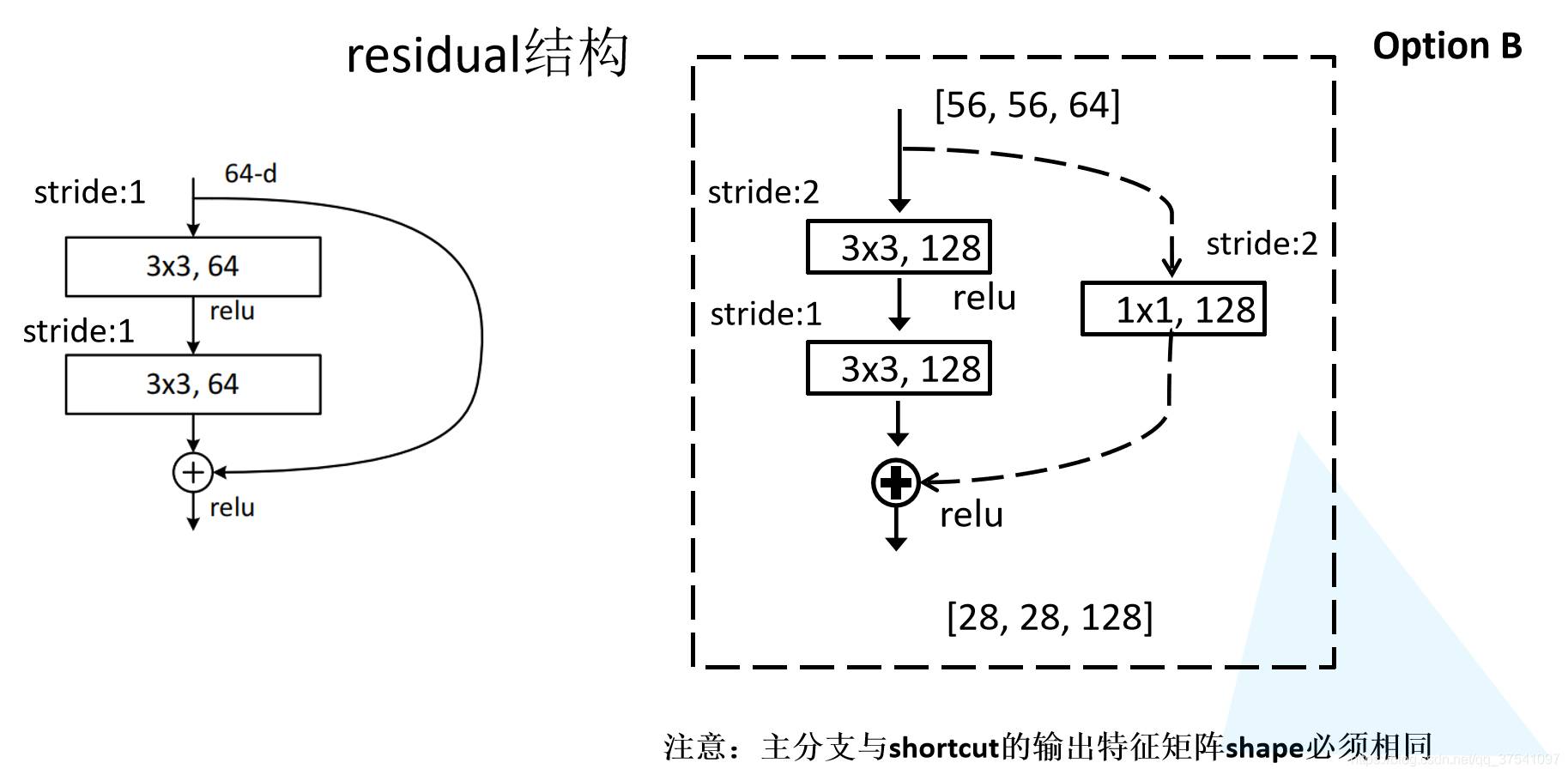

虚线残差结构

上图有两个残差结构,它们的区别在于:

左图的输入(Input)直接和输出(Output)相加,而右图的输入(Input2)需要经过一个1*1的卷积核,才能与输出(Output2)相加。

虚线残差第一个卷积的步距

stride=2,而实线残差结构stride=1

下图中,1号框的64表示卷积核的个数,等于输出深度。2号框的既是虚线残差结构

代码解析

resnet18/34的残差结构

BasicBlock如下图所示,它包括实线残差和虚线残差两种结构

# resnet18和resnet34的残差结构

class BasicBlock(nn.Module):# 卷积核个数改变的倍数,如果一样,则expansion=1expansion = 1# ----------------------------残差结构--------------------------------------------# in_channel 输入特征矩阵的深度# out_channel 输出特征矩阵的深度,既是卷积核的个数# stride 步距,当stride=1时,宽高不变,当stride=2时,宽高为原来的一半# downsample 下采样,默认为None。只有使用到虚线残差结构才设为True# bias=False 使用BN结构时,不需要使用偏置(bias)# -------------------------------------------------------------------------------def __init__(self, in_channel, out_channel, stride=1, downsample=None, **kwargs):super(BasicBlock, self).__init__()self.conv1 = nn.Conv2d(in_channels=in_channel, out_channels=out_channel,kernel_size=3, stride=stride, padding=1, bias=False)self.bn1 = nn.BatchNorm2d(out_channel)self.relu = nn.ReLU()self.conv2 = nn.Conv2d(in_channels=out_channel, out_channels=out_channel,kernel_size=3, stride=1, padding=1, bias=False)self.bn2 = nn.BatchNorm2d(out_channel)self.downsample = downsampledef forward(self, x):identity = x# 判断self.downsample是否为空,如果不为空,则进行实线的残差结构if self.downsample is not None:identity = self.downsample(x)# 主支线的正向传播out = self.conv1(x)out = self.bn1(out)out = self.relu(out)out = self.conv2(out)out = self.bn2(out)# 主线和残差相加out += identityout = self.relu(out)return out

下面的代码段,对应的是一次卷积操作

self.conv1 = nn.Conv2d(in_channels=in_channel, out_channels=out_channel,kernel_size=3, stride=stride, padding=1, bias=False)

self.bn1 = nn.BatchNorm2d(out_channel)

self.relu = nn.ReLU()

重复两次,既有

# ----------------------------残差结构--------------------------------------------# in_channel 输入特征矩阵的深度# out_channel 输出特征矩阵的深度,既是卷积核的个数# stride 步距,当stride=1时,宽高不变,当stride=2时,宽高为原来的一半# downsample 下采样,默认为None。只有使用到虚线残差结构才设为True# bias=False 使用BN结构时,不需要使用偏置(bias)# -------------------------------------------------------------------------------def __init__(self, in_channel, out_channel, stride=1, downsample=None, **kwargs):super(BasicBlock, self).__init__()self.conv1 = nn.Conv2d(in_channels=in_channel, out_channels=out_channel,kernel_size=3, stride=stride, padding=1, bias=False)self.bn1 = nn.BatchNorm2d(out_channel)self.relu = nn.ReLU()self.conv2 = nn.Conv2d(in_channels=out_channel, out_channels=out_channel,kernel_size=3, stride=1, padding=1, bias=False)self.bn2 = nn.BatchNorm2d(out_channel)self.downsample = downsample

self.downsample = downsample对应的下采样,即是用一个1*1的卷积实现虚线残差结构。如果self.downsample为空,机型实线残差。如果不为空,则进行虚线的残差结构

out += identity进行残差结构+主线结构

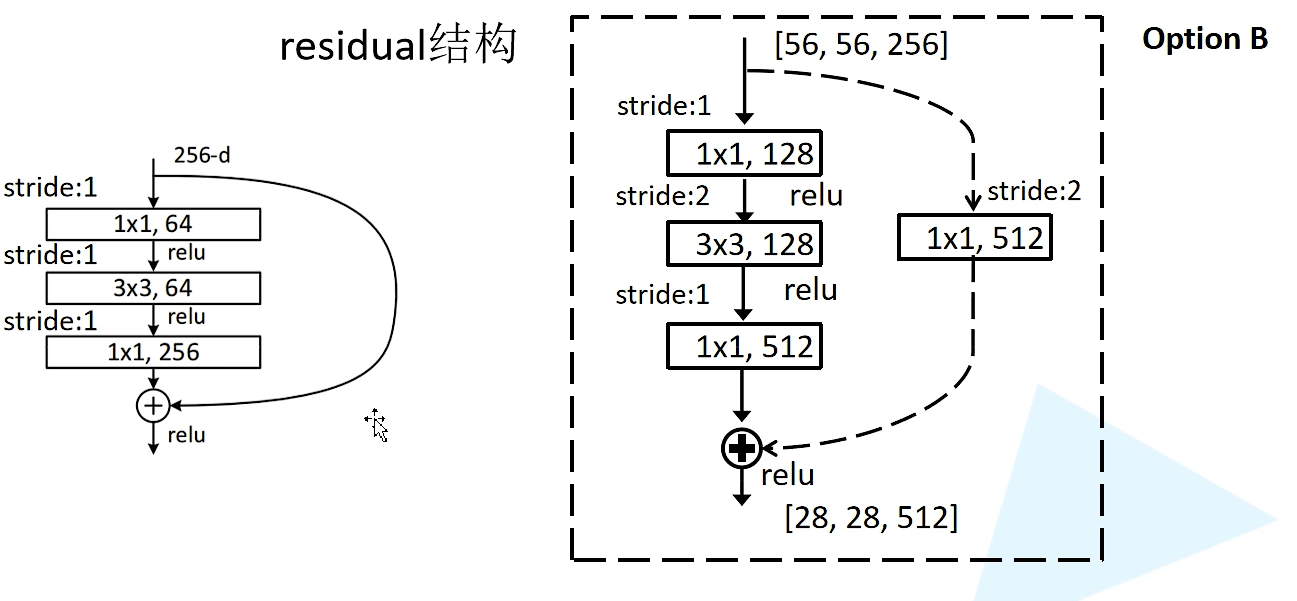

resnet50/101/152的残差结构Bottleneck

class Bottleneck(nn.Module):# 卷积核个数改变的倍数,这里主干上的输出深度为输入深度的4倍,则expansion=4expansion = 4def __init__(self, in_channel, out_channel, stride=1, downsample=None,groups=1, width_per_group=64):super(Bottleneck, self).__init__()width = int(out_channel * (width_per_group / 64.)) * groupsself.conv1 = nn.Conv2d(in_channels=in_channel, out_channels=width,kernel_size=1, stride=1, bias=False) # squeeze channelsself.bn1 = nn.BatchNorm2d(width)# -----------------------------------------self.conv2 = nn.Conv2d(in_channels=width, out_channels=width, groups=groups,kernel_size=3, stride=stride, bias=False, padding=1)self.bn2 = nn.BatchNorm2d(width)# -----------------------------------------self.conv3 = nn.Conv2d(in_channels=width, out_channels=out_channel*self.expansion,kernel_size=1, stride=1, bias=False) # unsqueeze channelsself.bn3 = nn.BatchNorm2d(out_channel*self.expansion)self.relu = nn.ReLU(inplace=True)self.downsample = downsample

Bottleneck与BasicBlock相似,仅在几个地方有些许差异

expansion = 4:conv1和conv3的输出深度分别为64、256,它们相差了4倍,即是expansion,它在self.conv3 = nn.Conv2d(in_channels=width, out_channels=out_channel*self.expansion,kernel_size=1, stride=1, bias=False)中被使用self.conv2 = nn.Conv2d(in_channels=width, out_channels=width, groups=groups,kernel_size=3, stride=stride, bias=False, padding=1):注意stride=stride,它对应着虚线残差结构中的conv2,stride=2

一层layer的结构(_make_layer()函数)

# ----------------------------一个layer的结构--------------------------------------

# block 残差结构,有BasicBlock、Bottleneck

# channel 与blocks_num对应,残差结构的卷积核数目,为一个列表。如resnet18为[2,2,2,2]

# block_num 该层一共包含了几个残差块,即使执行的次数

# -------------------------------------------------------------------------------

def _make_layer(self, block, channel, block_num, stride=1):downsample = None# 判断是resnet18/resnet34还是resnet50/resnet101/resnet152if stride != 1 or self.in_channel != channel * block.expansion:downsample = nn.Sequential(nn.Conv2d(self.in_channel, channel * block.expansion, kernel_size=1, stride=stride, bias=False),nn.BatchNorm2d(channel * block.expansion))# 若有downsample则为虚线残差结构,否则,仍是虚线残差结构layers = []layers.append(block(self.in_channel,channel,downsample=downsample,stride=stride,groups=self.groups,width_per_group=self.width_per_group))self.in_channel = channel * block.expansion# 实线残差结构for _ in range(1, block_num):layers.append(block(self.in_channel,channel,groups=self.groups,width_per_group=self.width_per_group))return nn.Sequential(*layers)

block:残差结构,有BasicBlock、Bottleneck

channel:与blocks_num对应,残差结构的卷积核数目,为一个列表。如resnet18为[2,2,2,2]

block_num:该层一共包含了几个残差块,即使执行的次数

downsample = None默认下采样为空,即默认不执行1*1卷积核的虚线残差结构if stride != 1 or self.in_channel != channel * block.expansion:默认in_channel=64,channel=64;对于18、34来说:expansion=1,所以self.in_channel != channel * block.expansion成立,故不进入if语句。对于50、101来说:expansion=4,所以不相等,进入if语句- if语句就是一个1*1的卷积操作

下图的【

ResNet网络的搭建相关推荐

- ResNet网络详解并使用pytorch搭建模型、并基于迁移学习训练

1.ResNet网络详解 网络中的创新点: (1)超深的网络结构(突破1000层) (2)提出residual模块 (3)使用Batch Normalization加速训练(丢弃dropout) (1 ...

- ResNet网络详解与keras实现

ResNet网络详解与keras实现 ResNet网络详解与keras实现 Resnet网络的概览 Pascal_VOC数据集 第一层目录 第二层目录 第三层目录 梯度退化 Residual Lear ...

- 1. Resnet网络详解

一.ResNet网络介绍 ResNet是2015年有微软实验室提出的,题目: 作者是何凯明等,这四个都是华人. 当年ResNet斩获了当年各种第一名.基本上只要它参加的比赛,全都是第一名. 我们来看一 ...

- pytorch实现简单的Resnet网络

笔者也是最近刚学不久的深度学习,也有很多地方不懂,下面给大家使用pytorch实现一个简单的Resnet网络(残差网络),并且训练MNIST数据集.话不多说,直接上代码. 笔者认为最主要的地方就是 ...

- ResNet网络结构的搭建(一)

目录 1.基本结构:BasicBlock和BottleNeck 2.构建ResNet网络 3.完整代码 代码部分参考b站视频 1.基本结构:BasicBlock和BottleNeck ResNet中最 ...

- ResNet网络的训练和预测

ResNet网络的训练和预测 简介 Introduction 图像分类与CNN 图像分类 是指将图像信息中所反映的不同特征,把不同类别的目标区分开来的图像处理方法,是计算机视觉中其他任务,比如目标检测 ...

- 搭建网络及服务器系统,网络服务器搭建与管理

网络服务器搭建与管理 内容精选 换一换 SAP生产环境安全解决方案如图1 生产环境安全解决方案全景图所示.根据业务特点,参考企业安全实践,建议将云上系统(生产环境.开发测试环境)划分为不同安全级别的多 ...

- CV之IG:基于CNN网络架构+ResNet网络进行DIY图像生成网络

CV之IG:基于CNN网络架构+ResNet网络进行DIY图像生成网络 目录 设计思路 实现代码 设计思路 实现代码 # 定义图像生成网络:image, training,两个参数# Less bor ...

- 渗透测试网络环境搭建

Kali Linux的网络环境搭建就不多说了,基本的两种上网方式,桥接(bridge)与NAT,同时如果是虚拟机的话必须要额外配置一块无线网卡(最好具备混杂模式)才可以直连wi-fi上网,代理也很简单 ...

最新文章

- 石子合并[DP-N3]

- 网络编程学习笔记一:Socket编程

- 使用COE脚本绑定SQL Profile

- php 主页子标题修改,关于有部分用户默认PC主页大标题标签修改无效的答疑.

- MySQL的or/in/union与索引优化

- 服务器虚拟化分为半,服务器虚拟化有哪些?

- CE驱动程序快速入门

- CF 4B. Before an Exam

- iso标准软件测试标准,软件质量-ISO9000标准+SQA简介

- 字节跳动《Vim 中文手册》火了,完整版 PDF 开放下载!

- 自主招生认可的英语竞赛有哪些

- 【DSP】DSP2833x.h中定义的指令EINT、DINT、ERTM、DRTM、EALLOW、EDIS、ESTOP0的含义

- 私域运营第五讲:实体餐饮店如何通过搭建私域流量实现营收增长

- The value of the property 'type' cannot be parsed

- python微信群管理_利用python实现在微信群刷屏的方法

- 由己及人,由人及“机”

- 如何搭建动态IP池?手把手教你3种方法!

- 16个免费高质量无版权图片视频网站分享,可以商用!

- mongoDB百度脑图总结

- python中父子进程